TRANSLATE START

title: “FunctionGemma: Googles winzige KI für Ihr Smartphone, kabellos” # Maximum 65 characters for SEO description: “Google hat FunctionGemma veröffentlicht, eine winzige KI mit 270 Mio. Parametern, die lokal auf Ihrem Smartphone läuft und Sprachbefehle ohne Cloud in Aktionen umwandelt. Privatsphäre und Geschwindigkeit, kabellos.” # Meta description: 25-160 characters slug: “functiongemma-googles-tiny-ai-for-your-phone-unplugged” categories: [“KI”, “Mobile”, “Software”] tags: [“functiongemma”, “google”, “on-device-ai”, “small-language-models”, “privacy”, “mobile-technology”]

TRANSLATE END

Technical

draft: false # false by default date: 2025-12-21 authors: [“Robot King”] featuredImage: “/images/shared/magazine/2025-12-21-image001-a514ee65.jpg” featured: true # featured by default

Source Attribution - we do not use this, place links into the content

source: "" # Original source URL (optional)

sourceAuthor: "" # Original author/creator (optional)

Translation metadata

translationKey: “a514ee65-86d0-470e-acda-cc68e35760af” sourceLanguage: “en-us” # Original content language translationStatus: “source” lastTranslated: 2025-12-21T18:51:07+00:00

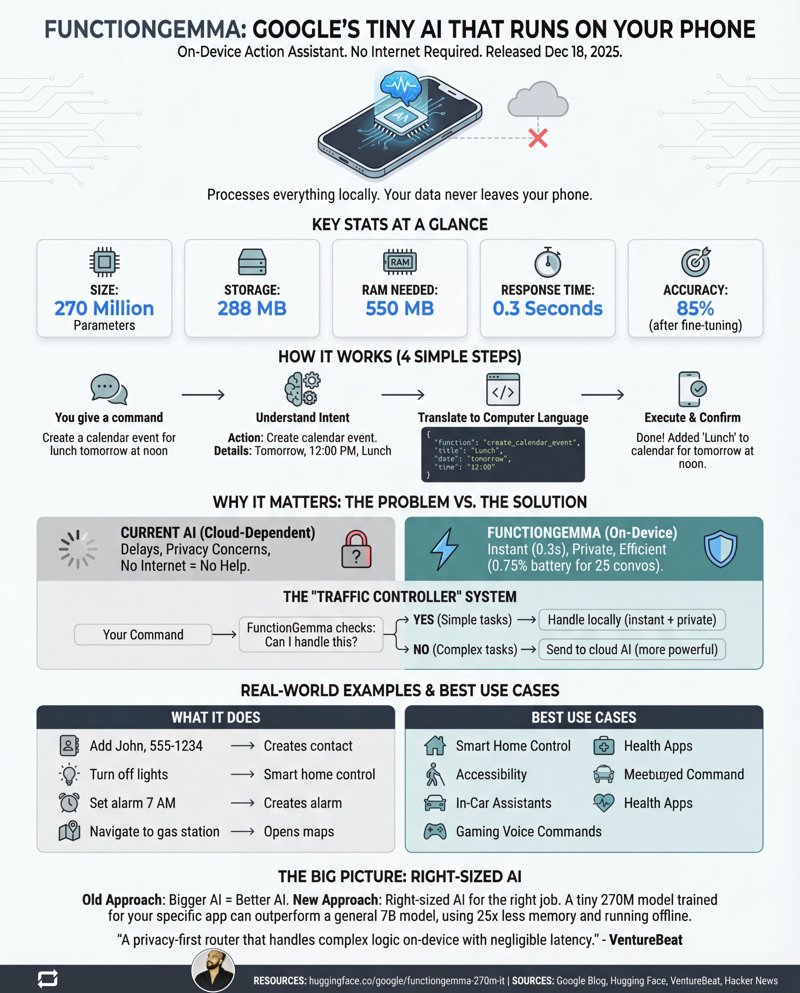

In einer Welt, in der KI-Unternehmen in einem brutalistischen Wettlauf um die größten digitalen Hirne gefangen sind, hat Google gerade etwas Urkomisches getan: Es hat ein Taschenformat-Hirn veröffentlicht. Am 18. Dezember 2025, mit der Aufregung eines unscheinbaren Software-Patch-Notes, schob Google klammheimlich FunctionGemma in die Welt hinaus. Dies ist kein weiterer Multi-Billionen-Parameter-Koloss, der in einem arktischen Rechenzentrum haust. Es ist ein winziges Modell mit 270 Millionen Parametern, das eine Sache außergewöhnlich gut kann: auf Ihrem Smartphone leben und Dinge erledigen, ganz ohne Internet.

Während der Rest der Branche “größer ist besser” skandiert, ist FunctionGemma eine erfrischende Prise Pragmatismus. Es ist eine spezialisierte Version des Gemma 3 270M-Modells, explizit auf “Function Calling” abgestimmt – die entschieden undankbare, aber entscheidende Aufgabe, Ihre gesprochenen Worte in Code zu verwandeln, den Ihr Gerät tatsächlich ausführen kann. Stellen Sie es sich weniger als konversationellen Philosophen vor und mehr als eine hocheffiziente Universalfernbedienung für die Funktionen Ihres Smartphones. Die gesamte Prämisse besteht darin, die Cloud-Verbindung für einfache Aufgaben zu kappen, wodurch Latenzzeiten, Datenschutzbedenken und die existenzielle Angst, ohne Empfang nutzlos zu sein, eliminiert werden.

Kleines Modell, große Auswirkungen

Reden wir über Zahlen, denn sie sind in der heutigen KI-Landschaft geradezu komisch. FunctionGemma ist ein Federgewichtschampion in einer Liga von Super-Schwergewichten.

- Parameter: 270 Millionen (zum Vergleich: GPT-4 wird auf Tausende Male größer geschätzt)

- Größe: Das Modell wiegt etwa 288 MB, kleiner als viele mobile Spiele, die Ihnen nur digitale Edelsteine verkaufen wollen.

- RAM-Nutzung: Es begnügt sich mit schlanken 550 MB RAM, um zu laufen.

- Reaktionszeit: Vergessen Sie die Hin- und Rückfahrt zur Serverfarm. Wir sprechen von 0,3 Sekunden für die On-Device-Verarbeitung.

- Datenschutz: 100 %. Ihr Befehl, “einen Timer für mein trauriges Schreibtisch-Mittagessen zu stellen”, verlässt niemals Ihr Gerät.

Hier geht es nicht nur darum, ein großes Sprachmodell zu schrumpfen. Es ist eine andere Philosophie. FunctionGemma wurde entwickelt, um die Brücke zwischen Ihrer natürlichen Sprache und der Software Ihres Smartphones zu sein, indem es als lokaler Agent agiert, der sofort einen Kontakt erstellen, Ihre Taschenlampe ein- oder ausschalten oder einen Kalendereintrag festlegen kann.

Das “Verkehrsregler”-Gambit

Google behauptet nicht, dass dieser 270-Millionen-Parameter-Winzling seine Cloud-basierten Titanen ersetzen wird. Stattdessen positioniert es ihn als intelligenten “Verkehrsregler”. Die Idee ist genial einfach: Wenn ein Befehl unkompliziert ist (“Schalte das Licht aus”), erledigt FunctionGemma ihn lokal für eine sofortige, private Antwort. Wenn Sie eine komplexere Frage stellen (“Was ist die Geschichte des Peloponnesischen Krieges und können Sie sie als Seemannslied zusammenfassen?”), kennt es seine Grenzen und leitet die Anfrage geschickt an ein leistungsfähigeres Cloud-basiertes Modell wie Gemma 3 27B weiter.

Dieser Hybridansatz bietet Ihnen das Beste aus beiden Welten: die Geschwindigkeit und den Datenschutz des Edge Computing für die 90 % der Aufgaben, die keine globalen Denkprozesse erfordern, und die rohe Leistung der Cloud, wenn Sie sie tatsächlich brauchen. Es ist ein System, das darauf ausgelegt ist, effizient zu sein, nicht nur mächtig.

Feintuning ist die Geheimzutat

Direkt aus der Box ist FunctionGemma nicht perfekt. In Googles eigener “Mobile Actions”-Evaluierung lag die Ausgangsgenauigkeit bei gründlich mittelmäßigen 58 %. Aber hier ist der entscheidende Teil: Es ist nicht dafür gedacht, direkt von der Stange verwendet zu werden. FunctionGemma ist eine Grundlage, ein Stück hoch formbarer Ton.

Nach dem Feintuning auf einem spezifischen Datensatz – in diesem Fall eine Liste gängiger Telefonbefehle – schoss seine Genauigkeit auf 85 % hoch. Dieser Sprung ist der ganze Punkt. Google teilt Entwicklern mit, dass ein kleines, spezialisiertes Modell, das auf Ihre spezifischen App-Funktionen trainiert wurde, ein massives, universelles Modell übertreffen kann, während es nur einen Bruchteil der Ressourcen verbraucht. Es ist ein Schritt hin zu maßgeschneiderten KI-Agenten, die Experten in ihrem engen Bereich sind, keine Tausendsassas.

Natürlich gibt es Einschränkungen. Das Modell hat derzeit Schwierigkeiten, mehrere Schritte aneinanderzuketten, und kann durch indirekte Anfragen aufs Glatteis geführt werden. Diese 85 % Genauigkeit bedeutet auch, dass es immer noch 15 % der Zeit falsch liegt, was zum Haare raufen sein könnte, wenn man nur versucht, einen Kontakt hinzuzufügen. Aber als Proof of Concept ist es ein mächtiges Statement.

Die Zukunft liegt in Ihrer Tasche, nicht nur in der Cloud

FunctionGemma ist mehr als nur ein neues Modell; es ist ein Signal, dass das KI-Wettrüsten in eine neue Phase eintritt. Die Fixierung auf den Bau immer größerer “Göttermodelle” weicht einer nuancierteren Strategie, bei der die passende KI für die passende Aufgabe eingesetzt wird. Für Entwickler öffnet dies die Tür zum Bau intelligenterer, schnellerer und privaterer Apps, ohne auf eine ständige, teure Nabelschnur zur Cloud angewiesen zu sein.

Für den Rest von uns bedeutet dies, dass der KI-Assistent in unserer Tasche deutlich reaktionsschneller und deutlich weniger unheimlich wird. Die Zukunft der KI ist nicht nur ein riesiges Gehirn in einer Serverfarm. Es sind Millionen winziger, spezialisierter Gehirne, die effizient genau dort arbeiten, wo wir sie brauchen. Und es sieht so aus, als wäre eines der ersten gerade in Ihr Smartphone eingezogen.