NVIDIA hat soeben den Fehdehandschuh im Rennen um das autonome Fahren hingeworfen und am 5. Januar 2026 Alpamayo angekündigt. Dabei handelt es sich nicht bloß um ein weiteres Modell zur Umfeldwahrnehmung, sondern um ein komplettes, offenes Ökosystem. Das Ziel: Autonomen Fahrzeugen das zu geben, was ihnen bisher schmerzlich fehlte – die Fähigkeit zu logischem Denken und zur Selbsterklärung. CEO Jensen Huang sprach vom Beginn eines „ChatGPT-Moments für physische KI“, der Autos dabei helfen soll, selbst seltene oder völlig neue Szenarien souverän zu durchdenken.

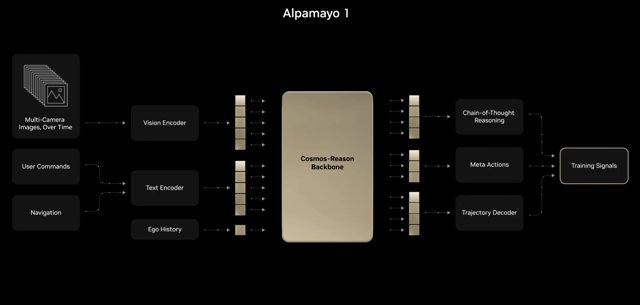

Das erste Release, Alpamayo 1, ist ein beeindruckendes Vision-Language-Action-Modell (VLAM). Auf gut Deutsch: Es verknüpft das, was das Auto sieht, mit einem sprachbasierten Verständnis, um daraus die richtige Aktion abzuleiten. Dies ermöglicht die Generierung „expliziter Argumentationspfade“ (reasoning traces). Im Klartext: Das Auto kann erklären, warum es sich entschieden hat, dem herrenlosen Einkaufswagen mit einem Schlenker auszuweichen. Um diese KI zu füttern, veröffentlicht NVIDIA zudem das Physical AI Dataset – eine gewaltige Bibliothek mit über 300.000 realen Fahrsequenzen aus mehr als 2.500 Städten.

Warum ist das so wegweisend?

Seit Jahren gleicht die Branche des autonomen Fahrens einer Vertrauensübung, bei der eine skeptische Öffentlichkeit die Hauptrolle spielt. Modelle, die als undurchsichtige „Black Boxes“ agieren, sind wenig dazu geeignet, dieses Vertrauen zu stärken. Mit dem Fokus auf Explainable AI (XAI), also einer KI, die ihre Entscheidungsprozesse artikulieren kann, geht NVIDIA das Akzeptanzproblem frontal an. Dieser Schwenk hin zu vernunftbasierten Modellen ist eine kritische – und wohl unumgängliche – Zutat, um endlich die hartnäckige Barriere von Level 3 zu durchbrechen. Das Ziel ist echtes autonomes Fahren auf Level 4, bei dem das Fahrzeug die meisten Situationen ohne menschliches Eingreifen meistert. Es geht nicht mehr nur darum, die Straße zu sehen, sondern sie endlich wirklich zu verstehen.